Sisällysluettelo:

- Kirjoittaja Lynn Donovan [email protected].

- Public 2023-12-15 23:46.

- Viimeksi muokattu 2025-01-22 17:23.

Kerätä (Toiminto) - Palauta kaikki tietojoukon elementit taulukkona ajuriohjelmassa. Tämä on yleensä hyödyllistä suodattimen tai muun toiminnon jälkeen, joka palauttaa riittävän pienen osajoukon tiedoista.

Mikä PySpark tällä tavalla on?

PySpark Ohjelmointi. PySpark on Apache Sparkin ja Pythonin yhteistyö. Apache Spark on avoimen lähdekoodin klusterilaskentakehys, joka on rakennettu nopeuden, helppokäyttöisyyden ja suoratoistoanalytiikan ympärille, kun taas Python on yleiskäyttöinen korkean tason ohjelmointikieli.

Lisäksi mikä on kartta PySparkissa? Kipinä Kartta Muutos. A kartta on muunnosoperaatio Apache Sparkissa. Se koskee jokaista RDD:n elementtiä ja se palauttaa tuloksen uutena RDD:nä. Kartta muuntaa RDD:n, jonka pituus on N, toiseksi RDD:ksi, jonka pituus on N. Tulo- ja lähtö-RDD:illä on tyypillisesti sama määrä tietueita.

Tällä tavalla mikä on SparkContext PySparkissa?

PySpark - SparkContext . Mainokset. SparkContext on pääsypiste mihin tahansa kipinä toiminnallisuutta. Kun ajamme mitä tahansa Kipinä sovellus, ajuriohjelma käynnistyy, jossa on päätoiminto ja sinun SparkContext aloitetaan täällä. Ajuriohjelma suorittaa sitten operaatiot suorittajien sisällä työntekijäsolmuissa.

Kuinka tarkistan PySpark-version?

2 vastausta

- Avaa Spark Shell Terminal ja kirjoita komento.

- sc.version Tai spark-submit --version.

- Helpoin tapa on käynnistää "spark-shell" komentoriviltä. Se näyttää.

- Sparkin nykyinen aktiivinen versio.

Suositeltava:

Mikä on w3c mikä on Whatwg?

Web Hypertext Application Technology Working Group (WHATWG) on HTML:n ja siihen liittyvien teknologioiden kehittymisestä kiinnostuneiden ihmisten yhteisö. WHATWG:n perustivat vuonna 2004 Apple Inc:n, Mozilla Foundationin ja Opera Softwaren, johtavien verkkoselaintoimittajien henkilöt

Miten tietoja voidaan kerätä?

Ensisijaisten kvantitatiivisten tietojen keräämiseen on useita menetelmiä. Joihinkin liittyy tietojen kysyminen suoraan asiakkailta, joihinkin liittyy vuorovaikutuksen seuraaminen asiakkaiden kanssa ja toisiin asiakkaiden käyttäytymisen tarkkaileminen. Oikea käyttö riippuu tavoitteistasi ja keräämäsi datan tyypistä

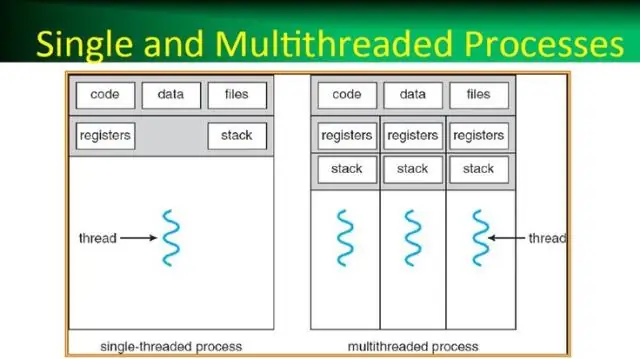

Mikä on prosessi käyttöjärjestelmässä mikä on säiettä käyttöjärjestelmässä?

Prosessi on yksinkertaisimmillaan suorittava ohjelma. Yksi tai useampi säiettä suoritetaan prosessin yhteydessä. Säie on perusyksikkö, jolle käyttöjärjestelmä varaa prosessoriaikaa. Säiepoolia käytetään ensisijaisesti vähentämään sovellussäikeiden määrää ja tarjoamaan työsäikeiden hallintaa

Mistä voin kerätä tietoja?

7 tapaa kerätä kyselyitä. Kyselyt ovat yksi tapa kysyä suoraan asiakkailta tietoja. Online-seuranta. Tapahtumatietojen seuranta. Online-markkinointianalyysi. Sosiaalisen median seuranta. Tilaus- ja rekisteröintitietojen kerääminen. Myymälän liikenteen valvonta

Kuinka teen PySpark DataFramen luettelosta?

Noudatan näitä vaiheita luodakseni DataFramen monikkoluettelosta: Luo monikkoluettelo. Jokainen monikko sisältää henkilön nimen iän mukaan. Luo RDD yllä olevasta luettelosta. Muunna jokainen monikko riviksi. Luo DataFrame ottamalla käyttöön createDataFrame RDD:llä sqlContextin avulla